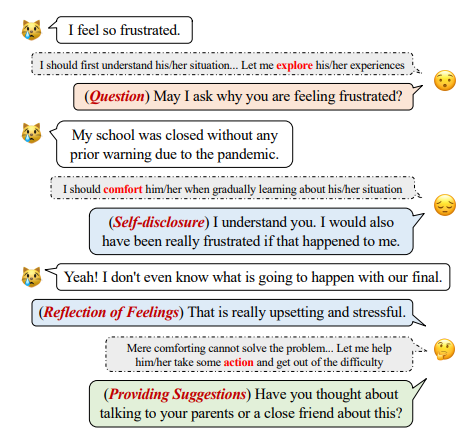

오늘은 ExTensible Emotional Support(ExTES) dialog Dataset에 대해 리뷰해보려고 한다. 이 데이터셋은 ESConv Dataset에 문제점에 대해 파악하고 더 많은 데이터셋과 Strategy와 scenarios를 갖고 있다. 논문 링크https://arxiv.org/pdf/2308.11584 Introduction오늘날에는 Emotinoal Support Converstion은 개인의 well-being을 증가하는데 매우 중요한 역할을 한다. 이러한 대화는 감정을 자유롭게 표현하는 공간을 만들어 개인의 감정을 나누어 더욱 좋은 정신적 건강을 유지할 수 있도록 한다. 이러한 Emotional Support(ES)는 대두되는 중요성에도 불구하고 대규모의 라벨링된 데이터는..