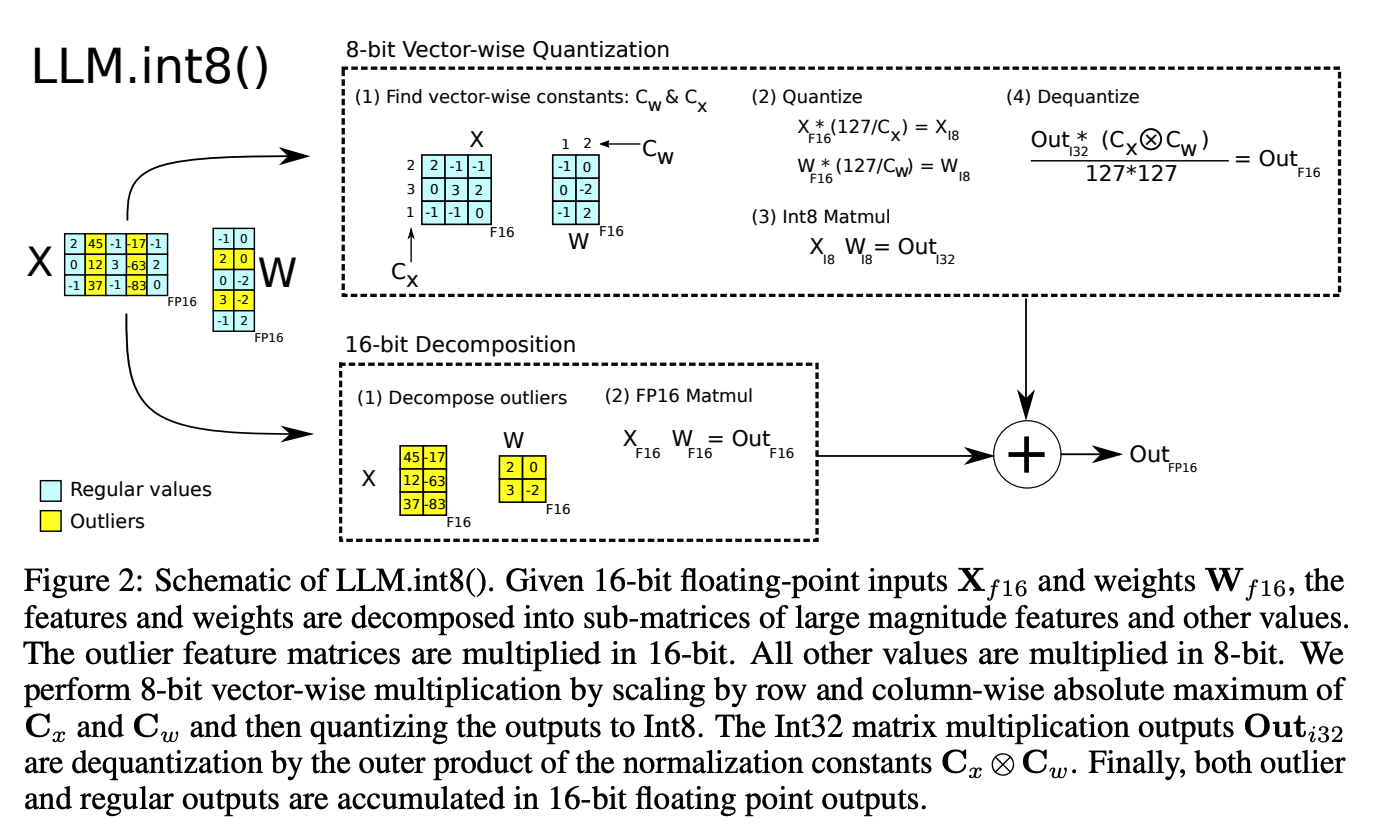

논문링크(Published at NeurIPS 2022)https://arxiv.org/abs/2208.07339Introduction최근에 사용하는 Large Langugage Models(LLMs)는 추론을 위해 상단한 메모리를 요구한다. 이와 관련해서 LoRA(LoRA: Low-Rank Adaptation of Large Language Models) 기술이 나왔다. 파라미터의 사이지를 줄이는 기술 중 하나로 파라미터를 더 낮은 비트로 양자화하고 낮은 비트 정확도 행렬곱을 사용한다. 이 논문에서는 트랜스포머 라이브러리의 8비트 양자화 방법대해서 개발했다. 이 방법을 통해서 성능은 유지하며 이전보다 더 낮은 메모리 할당량을 갖게하려고 한다. 이전 기술은 350M 파라미터보다 적은 경우엔 충분히 좋았지..